Le web scraping, processus d’extraction d’informations à partir de sites web, est devenu de plus en plus important dans le monde actuel orienté vers les données. Python, un langage de programmation de haut niveau connu pour sa lisibilité et son vaste écosystème de bibliothèques, est largement utilisé dans ce domaine en raison de sa simplicité et de son efficacité.

Les bibliothèques Python pour le Web Scraping

Il existe de nombreuses bibliothèques en Python pour le web scraping, mais les plus utilisées sont Beautiful Soup et Requests.

- Beautiful Soup : C’est une bibliothèque Python utilisée pour analyser les documents HTML et XML. Elle crée des arbres d’analyse à partir du code source de la page, ce qui facilite l’extraction de données.

- Requests : Une bibliothèque simple mais puissante pour envoyer des requêtes HTTP. Elle est utilisée pour récupérer le contenu HTML d’une page web.

Web Scraping avec Beautiful Soup et Requests

Entrons plus en détail dans le code pour scraper un blog en utilisant Beautiful Soup et Requests.

Installation des bibliothèques

D’abord, nous devons installer ces bibliothèques si elles ne sont pas déjà installées. Cela peut être fait en utilisant pip, le gestionnaire de paquets de Python :

pip install beautifulsoup4 requestsImportation des bibliothèques

Après l’installation, nous commençons notre script en important les bibliothèques nécessaires.

import requests

from bs4 import BeautifulSoupEnvoi d’une requête GET

Ensuite, nous faisons une requête GET au site web que nous voulons scraper. La requête GET indique que nous voulons accéder à des informations à partir de l’URL spécifique.

r = requests.get("http://www.exampleblog.com")Analyse du contenu HTML

Après avoir fait la requête, nous analysons le contenu HTML de la page. Cette étape consiste à structurer le contenu HTML dans un format qui est facile à lire et à naviguer.

soup = BeautifulSoup(r.text, 'html.parser')Extraction d’informations

Avec le HTML analysé, nous pouvons maintenant extraire les informations que nous voulons. Extrayons le titre de la page et le texte de tous les paragraphes.

Extraction du titre de la page

En HTML, le titre de la page est généralement encadré par des balises ‘title’. Nous utilisons ‘.title.text’ de Beautiful Soup pour y accéder :

page_title = soup.title.textExtraction des paragraphes

Pour extraire les paragraphes, nous utilisons la méthode ‘find_all’. En HTML, les paragraphes sont souvent encadrés par des balises ‘p’. Cette méthode renvoie tous les paragraphes de la page :

paragraphs = soup.find_all('p')Impression des informations extraites

Enfin, nous imprimons les informations que nous avons extraites. Nous imprimons d’abord le titre, puis nous itérons sur les paragraphes et imprimons chacun d’eux.

print(f"Titre de la Page : {page_title}")

for p in paragraphs:

print(p.text)Le Code Complet

Voici l’ensemble du code :

import requests

from bs4 import BeautifulSoup

# Envoyer la requête GET

r = requests.get("https://www.awinstall.com")

# Analyser le contenu HTML

soup = BeautifulSoup(r.text, 'html.parser')

# Extraire le titre de la page

page_title = soup.title.text

# Extraire tous les paragraphes

paragraphs = soup.find_all('p')

# Imprimer le titre de la page

print(f"Titre de la Page : {page_title}")

# Imprimer chaque paragraphe

for p in paragraphs:

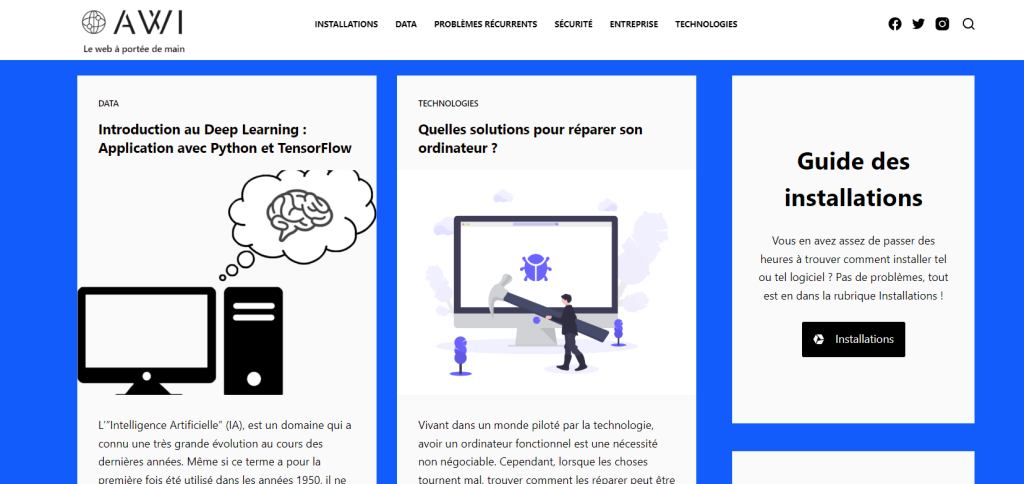

print(p.text)Voici le résultat obtenu pour la page d’accueil du site awinstall.com :

Page Title: All Web Install – Le web à portée de main Le web à portée de main

Le web à portée de main L’”Intelligence Artificielle” (IA), est un domaine qui a connu une très grande évolution au cours des dernières années. Même si ce terme a pour la première fois été utilisé dans les années 1950, il ne s’est démocratisé que à partir… Vivant dans un monde piloté par la technologie, avoir un ordinateur fonctionnel est une nécessité non négociable. Cependant, lorsque les choses tournent mal, trouver comment les réparer peut être une tâche ardue. Dans cet article, nous présentons différentes solutions disponibles… Qu’est-ce qu’Apache Kafka ? Apache Kafka est une plateforme de streaming d’événements distribuée open-source développée par la Apache Software Foundation. Elle est conçue pour gérer des flux de données en temps réel avec un haut débit et une faible latence.… Le lancement d’une marketplace est une manœuvre délicate. C’est l’une des raisons pour lesquelles il faut utiliser des outils spécifiques. Découvrez ici les astuces à suivre pour choisir la solution logiciel pour lancer votre marketplace. Tenir compte des caractéristiques de… Lorsque vous écrivez un programme informatique, l’efficacité est un facteur clé à prendre en compte. En cherchant à maximiser la performance de votre code, vous pouvez être amené à vous questionner sur les différentes techniques qui permettent de rendre un… Introduction Rencontrer des problèmes techniques avec votre Bbox peut être frustrant, surtout lorsqu’un code d’erreur apparaît sans solution apparente. Parmi ces codes, le F3411 est courant et indique un souci de réception du signal TV. Voici des étapes faciles pour… Avec l’explosion des données numériques, les entreprises se tournent vers les architectures Big Data pour manipuler et analyser des volumes massifs de données. Trois architectures dominent le paysage : Batch Processing, Stream Processing et Lambda Architecture. Chacune offre des avantages… Dans le monde de l’entreprise actuel, la gestion de l’informatique est une tâche complexe qui requiert une attention et des compétences spécialisées. Le rythme rapide de l’évolution technologique et la nécessité vitale de sécuriser les données posent des défis majeurs.… La souris d’ordinateur, élément fondamental de notre interaction avec la technologie numérique, se présente sous diverses formes pour répondre à une multitude de besoins. Dans cet article, nous nous concentrerons sur trois types spécifiques : la souris de bureau classique,… Dans le monde dynamique des Sociétés de Services et d’Ingénierie Informatique (SSII), encore appelées Entreprises de Service Numérique (ESN), un CV bien conçu peut faire toute la différence pour se démarquer des autres candidats. Dans cet article, nous allons passer… Vous en avez assez de passer des heures à trouver comment installer tel ou tel logiciel ? Pas de problèmes, tout est en dans la rubrique Installations ! La data est une source inépuisable de connaissances et de possibilités : elle nous permet de mieux comprendre le monde qui nous entoure et de développer de nouvelles solutions pour résoudre les défis de demain.

Conclusion

Ceci est un exemple simple, mais il sert à illustrer la puissance et la flexibilité de Python dans les tâches de web scraping. Beautiful Soup et Requests sont des outils puissants de l’écosystème Python qui vous permettent de transformer des données web non structurées en informations structurées et utilisables. Cependant, assurez-vous toujours que vos activités de web scraping respectent les règles et politiques des sites web ainsi que les réglementations légales.